Codzienny trening ślepoty

Widzimy inteligencję tam, gdzie jej nie ma – z Lauren Huret, artystką badającą styk nowych technologii i mistyki, rozmawia Ada Banaszak

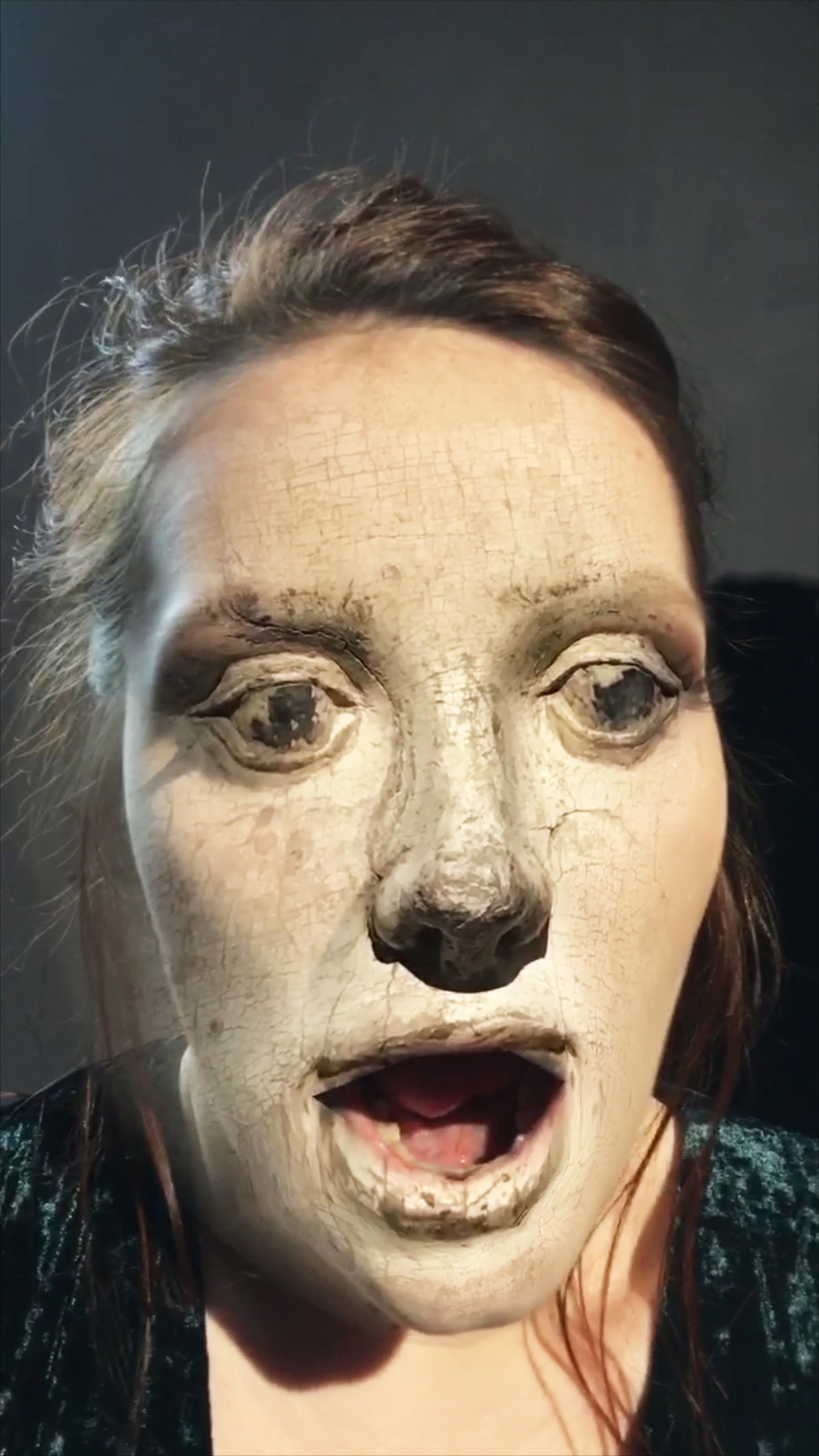

Lauren Huret, Ways of Non-Seeing, dzięki uprzejmości artystki

W swojej praktyce artystycznej badasz relacje pomiędzy nauką, technologią, umysłem a zachowaniem i wierzeniami ludzi. Czym w kontekście twoich poszukiwań, są „sposoby niewidzenia”, którym poświęciłaś swoją pracę podsumowującą półroczną rezydencję w A-I-R Laboratory w Warszawie?

Tytuł performansu – Ways of Non-Seeing – oznacza przede wszystkim to, że wszystkie technologie, które rozwijamy, wcale nie pomagają nam w zrozumieniu świata. Wychodzę z założenia, że każdy przekaz, który krąży w internecie – czy jest to prasowy news, zdjęcie czy komentarz pod postem – wywołuje w nas emocje. Nie możemy tak po prostu przeczytać o tym, że w Aleppo zginęły trzy tysiące ludzi i bez mrugnięcia okiem pójść dalej. Kiedy wrzucasz na Facebooka zdjęcie kotka, chcesz wywołać u swoich znajomych jakąś reakcję. Obraz zawsze kłamie, ponieważ zawsze ma ukryty cel o emocjonalnym charakterze. Dlatego uważam, że uczestnictwo w portalach społecznościowych i udawanie aktywności, udawanie, że w jakiś sposób nasza obecność on-line odzwierciedla nasze życie, jest treningiem ślepoty.

Udawanie, że jest się aktywnym? Czyli to, co robimy w mediach społecznościowych, to nie jest prawdziwa aktywność?

I tak, i nie. Dla mnie internet jest kolejną warstwą rzeczywistości, rządzącą się swoimi prawami. Jednym z celów mojego performansu było zwrócenie na to uwagi. Zaprosiłam uczestników do zabrania głosu na forum – mogli dzielić się z innymi osobami obecnymi na sali swoimi najgłębszymi obawami oraz najbardziej żenującymi historiami. W internecie robimy to na co dzień. Chciałam zobaczyć, czy widzimy różnicę pomiędzy napisaniem komentarza pod zdjęciem na Instagramie, a dzieleniem się myślami z innymi ludźmi twarzą w twarz, w ramach pewnego rodzaju grupowej terapii. Przede wszystkim chodziło mi jednak o to, żeby sprowokować ludzi do przemyślenia ich relacji z urządzeniami, z którymi spędzają niemal cały czas. Jeżeli ktokolwiek mówi mi, że świetnie sobie radzi ze swoim smartfonem, to znaczy, że tak naprawdę nie radzi sobie z nim wcale. Zawsze udajemy, że nad wszystkim panujemy, ale tak naprawdę nie mamy pojęcia o wpływie mediów społecznościowych na nasze codzienne życie. Próbujemy to jakoś zrozumieć, wydaje nam się, że jesteśmy wszystkiego świadomi i niezwykle krytyczni, ale na to jest po prostu za wcześnie. Nie można mieć spojrzenia z dystansu na coś, w czym siedzi się po uszy. Jedna z osób biorących udział w performansie na pytanie, ile razy dziennie używa swojego smartfona, odpowiedziała, że cały czas. Do opisania swojej relacji ze smartfonem większość ludzi użyła określeń takich jak „niewolnictwo”, „uzależnienie”, „brak kontroli”. To zupełnie nowa sytuacja – 10 lat temu nikt nie patrzył na swój telefon przez 2/3 doby.

Może po prostu chcemy poddać się technologii?

Nie wiem, to raczej pytanie do psychoanalityka… Ale ja mogę śmiało powiedzieć, że kocham swój komputer. Włączam go od razu po przebudzeniu, a potem przez niemal cały dzień siedzę w internecie, szukając, przeglądając i tworząc treści. Uwielbiam to i tak spędzam niemal każdy dzień. Gdybym nie chciała, żeby komputer sterował moim życiem, to coś bym zmieniła. Ale nie robię w tym kierunku nic.

W grudniu zeszłego roku razem z Hunterem Longe wystawiliśmy w Lozannie sztukę teatralną Deep Blue Dream – tytuł jest zlepkiem nazw sławnych systemów komputerowych działających według algorytmów sztucznej inteligencji – w ramach której poruszamy kwestię relacji między człowiekiem i maszyną. Punktem wyjścia były dla nas wydarzenia z lat 1996-1997. W pierwszym roku Garri Kasparow wygrał partę szachów z komputerem IBM, w drugim przegrał rozgrywkę, ponieważ korporacja usprawniła oprogramowanie maszyny. Uznaliśmy to za ważny punkt zwrotny. Wygrana komputera Deep Blue w starciu z geniuszem, jakim jest Kasparow, stała się ostatecznym dowodem na to, że poddanie się logice maszyn jest dla ludzi jedyną drogą do rozwoju. W ramach performansu Deep Blue Dream postawiliśmy na scenie komputer z lat 90. i podłączyliśmy do dwóch ekranów. W pierwszej części performansu maszyna opowiada o swoim życiu, przechwalając się, przywołując różne historie i zabawiając zebranych w teatrze ludzi. Nagle gaśnie światło, a na ekranach zaczynają pojawiać się twarze osób siedzących na sali, nagrane przez ukryte kamery CCTV. Następnie miejsce tych obrazów zajmują zdjęcia z profilów społecznościowych tych samych osób, a towarzyszy im wypowiadana przez komputer litania informacji, które uczestnicy performansu udostępnili o sobie w internecie.

Lauren Huret, iPhone Torture, dzięki uprzejmości artystki

To faktycznie dosyć spektakularny sposób na ujawnienie tych relacji, szczególnie, jeżeli będziemy pamiętać, że za maszyną i jej działaniami stoi człowiek… Dziś często mówi się o tym, że ludzie porzucili wielkie, wizjonerskie plany rozwoju technologicznego – zamiast latających samochodów i podróży w kosmos mamy iphony, śledzące nas media społecznościowe i szaloną biurokrację. W ramach swojej praktyki artystycznej przeprowadziłaś dość obszerne badanie dotyczące sztucznej inteligencji, którego rezultatem jest m.in. książka Artificial Fear Intelligence of Death[1] – zbiór rozmów ze specjalistami od A.I. z Doliny Krzemowej. Z jakimi wizjami przyszłości tej technologii zetknęłaś się w San Francisco?

To dosyć złożony temat. Poza faszystowskim ruchem singularitariańskim – czyli ludźmi, którzy chcą, aby maszyny zniszczyły ludzkość – inne osoby, które poznałam i które pracują nas rozwojem sztucznej inteligencji wierzą, że ta technologia może znacząco usprawnić codzienne życie. Kiedy rozmawiasz z programistami, odnosisz wrażenie, że ich jedynym celem jest stworzenie lepszego świata, a duże sumy pieniędzy zarabiają po prostu przy okazji. Cała przewrotność tej sytuacji polega na tym, że ci, którzy piszą kod w Dolinie Krzemowej mają zawsze dobre intencje, ale nie zmienia to faktu, że A.I. jest używana w dronach, które zabijają ludzi czy w inwazyjnych narzędziach marketingowych. Brakuje refleksji nad tym, że technologia automatycznie nie zmieni świata na lepsze, tylko po prostu go zmieni i że każdy wynalazek może być użyty na rozmaite sposoby.

Czy mogłabyś powiedzieć coś więcej o tych faszystowskich singularitarianach? Co to za jedni?

Najbardziej radykalni singularitarianie są wyznawcami technologicznego darwinizmu – wierzą, że maszyny w sposób naturalny staną się samoświadome, że jest to po prostu kolejny krok w ewolucji. Według nich sztuczna inteligencja rozwinie się tak samo, jak człowiek rozwinął się z bardziej „prymitywnych” stworzeń, małpy czy Neandertalczyka. Maszyny uznają za część natury, ponieważ są one stworzone z surowców znalezionych na Ziemi. Jeżeli zwrócisz im uwagę na kwestie związane z zanieczyszczeniem środowiska spowodowanym przez rozwój technologii, np. problem elektrośmieci, powiedzą ci, że natura też produkuje toksyny, radioaktywność itp. Ten tor myślenia prowadzi do konkluzji, że skoro maszyny są takie wspaniałe i takie naturalne, a przy okazji działają w logiczny sposób, to powinny po prostu przejąć kontrolę nad ludźmi. Na szczęście singularitarianie to niezbyt liczna grupa.

Z drugiej strony, kiedy myślę o idealistach, którzy technologię chcą wykorzystywać do naprawiania świata – świetną satyrą na to jest serial Silicon Valley – przed oczami staje mi Elon Musk[2], który w ostatnim filmie Wernera Herzoga Lo i stało się opowiada o tym, że trzeba skolonizować Marsa, na wypadek gdyby „coś poszło nie tak na Ziemi”.

Tak, to było naprawdę doskonałe! A z drugiej strony – czemu miałby tak nie uważać? Tak jak każdy z nas, Elon Musk żyje swoją własną fikcją. I tak samo jak jego fikcja, nasze fikcje też odciskają piętno na innych ludziach. Może nasza praca nie ma takiego zasięgu, jak złote myśli Elona Muska, ale też ma znaczenie.

Ciekawe w kontekście tego hurra-optymizmu Doliny Krzemowej są mroczne wizje dotyczące przyszłości sztucznej inteligencji kreowane przez popkulturę, zdecydowanie bliższe marzeniom singularitarian niż faktycznym osiągnięciom i celom osób pracujących nad rozwojem tej technologii. Skąd biorą się te wyobrażenia o robotach jako zagrożeniu dla człowieka?

Z każdym tematem jest tak samo – z jednej strony twarde fakty, z drugiej wizja, którą media, Hollywood i korporacje zaszczepiają w naszych mózgach, czy nam się to podoba, czy nie. Ludzie boją się sztucznej inteligencji – to strach związany z nieznanym, z obcym życiem, z utratą tożsamości – a popkultura ten strach podsyca. Sztuczna inteligencja staje się szerokim ciemnym polem, na które ludzie projektują swoje lęki, ponieważ jest to bardzo szerokie zagadnienie, trudne do ogarnięcia umysłem. Jak pisze Donna Haraway, bez fantazjowania o takich złożonych konstrukcjach nie jesteśmy w stanie sobie poradzić z ich istnieniem. Sztuczna inteligencja jest tak trudna do przedstawienia, tak abstrakcyjna, że nasz umysł zawsze będzie się starał czymś zapełnić tę poznawczą pustkę. Jeżeli zobaczysz robota zachowującego się i reagującego zupełnie jak zwierzę[3], będziesz albo przerażona, albo kompletnie zafascynowana – ale w takiej maszynie nie ma krztyny inteligencji. To tylko maskarada, mimikra. Jednak nasz mózg nie może poradzić sobie z tą „czarną magią” i przez to widzimy inteligencję tam, gdzie jej nie ma.

A czym jest twoim zdaniem inteligencja?

Wiele osób łączy inteligencję – szczególnie, jeżeli zadajesz to pytanie w kontekście sztucznej inteligencji – z umiejętnością przetwarzania informacji i podejmowania decyzji w oparciu o logiczne rozumowanie. Nie możemy jednak sprowadzać inteligencji do obróbki danych! Choć istnieje wiele dużo bardziej precyzyjnych definicji, ja powiedziałabym, że dla mnie inteligencja to umiejętność budowania mostów opartych na empatii pomiędzy sobą i innymi bytami w świecie.

Lauren Huret, Inception, dzięki uprzejmości artystki

Odnoszę wrażenie, że maszyny przedstawiane w popkulturze stają się coraz bardziej „empatyczne” i emocjonalnie bliskie ludziom. Starcie człowieka z maszyną nie jest już oparte na przemocy fizycznej, jak w Terminatorze czy RoboCopie, ale rozgrywce psychologicznej – jak na przykład w filmie Ex-Machina, w którym młody mężczyzna zostaje uwikłany w dziwną relację z robotem-kobietą, na której ma przeprowadzić test Turinga.

Detale popkulturowych opowieści muszą wciąż się zmieniać, jednak sedno pozostaje takie samo. Hollywood opowiada fantastyczne historie i będzie je opowiadać tak, by nadążały za duchem czasu – jednak zawsze będą to tylko historie. Sprawa się komplikuje, kiedy te historie stają się rzeczywistością, a wydarza się to w momencie, w którym ludzie zaczynają uważać je za prawdę. Zanim pojechałam do San Francisco żeby pracować nad projektem Artificial Fear Intelligence of Death, przygotowałam krótki kwestionariusz składający się z 38 prostych pytań dotyczących sztucznej inteligencji, którym badałam osoby niezajmujące się zawodowo tym tematem. Kiedy pytałam o źródło ich wiedzy dotyczącej A.I., około 90% osób wskazywało fikcyjne referencje. Ludzie opowiadali historie z filmów science fiction, jednocześnie twierdząc, że ich znajomość tematu jest całkiem niezła. To tak jakbyś zapytała kogoś o sytuację polityczną w Stanach Zjednoczonych, a on zacząłby ci streszczać serial House of Cards. W tym kwestionariuszu jednym z najciekawszych pytań okazało się to, w którym prosiłam respondentów o ocenienie poziomu swojej wiedzy dotyczącej sztucznej inteligencji w skali od 0 do 10. Wszystkie kobiety wskazywały cyfrę poniżej 5, zwykle 2, a mężczyźni oscylowali ok. 6 – 8, nawet jeżeli całą swoją wiedzę dotyczącą A.I. czerpali z Łowcy androidów.

To już przecież poziom ekspercki! Czyli twierdzisz, że w przypadku technologii mamy problem z odróżnieniem fikcji od rzeczywistości? Czy myślisz, że jest to szerszy problem, w jakiś sposób związany z niemożliwością „przerobienia” gigantycznej ilości danych, które dziś produkujemy, publikujemy i znajdujemy on-line?

Oczywiście, z jednej strony mamy algorytm, który popycha nas w tylko sobie znanych kierunkach, z drugiej – zalewają nas fale informacji i toniemy pod naporem obrazów. Mój kolejny projekt będzie poświęcony osobom, które zajmują się moderowaniem treści w mediach społecznościowych. To naprawdę przerażająca praca – chciałabym z nimi porozmawiać o tym, co czują, oglądając przez cały dzień najgorsze i najbardziej przerażające wytwory ludzkości; zdjęcia, które przecież nie są tylko plamami kolorów, ale czymś, co sprawia, że twój mózg myśli: „to się stało naprawdę”. Statystyki wskazują, że większość z osób wykonujących taka pracę po kilku miesiącach wpada w głęboką depresję, wiele z nich cierpi również na silne halucynacje. Wizje, z którymi na co dzień obcują, po prostu z nimi zostają. Jako artystka chcę pokazać, w jaki sposób obraz może stać się przekleństwem, czymś, co wysysa z ciebie duszę i kładzie się cieniem na twoją egzystencję. To, że istnieją obrazy, które mogą zmienić całe twoje życie, jest czymś stosunkowo nowym. Nie chodzi mi o odczytywanie przedstawień, ich kulturowe znaczenie czy ukryty przekaz – tym zajmował się chociażby wspaniały John Berger[4] – ale o zupełnie nowe sposoby (nie)radzenia sobie z obrazami. O pracę, która przez swój wizualny wymiar może zawładnąć twoim umysłem.

Lauren Huret, Sposoby niewidzenia (Ways of Non-Seeing), Warszawa 2017. Fot. Dzięki uprzejmości A-I-R Laboratory CSW Zamek Ujazdowski w Warszawie

Muszę przyznać, że dla mnie szokiem było odkrycie, że moderacją treści w mediach społecznościowych zajmują się ludzie – dowiedziałam się o tym dzięki pracy Dark Content Evy i Franco Mattesów. Wcześniej byłam pewna, że ta czynność jest w pełni zautomatyzowana. Coraz częściej mam wrażenie, że wiedza dotycząca tego, czym zajmuje się człowiek, a czym maszyna, jest niedostępna, a przynajmniej, że jest w tym temacie dużo niedomówień.

To, o czym mówisz, było jednym z powodów dla których zainteresowałam się tym tematem. Wiele osób uważa, że „brudną robotę” w internecie wykonuje jakiś algorytm lub użytkownicy mediów społecznościowych, którzy zgłaszają takie treści do moderacji. Nie wiemy, że takie zgłoszenie jest oceniane przez ludzi, którzy przy pomocy specjalnego oprogramowania decydują, czy powinno być usunięte z danego portalu. Ci pracownicy mają swoje specjalizacje – są sekcje zajmujące się seksem, czyli oglądaniem 8 godzin dziennie wagin i penisów, są ludzie pracujący w działach kontrolujących obrazy przemocy wojenne itd. Mimo, że staram się drążyć ten temat, jestem daleka od posiadania pełnej wiedzy. W Warszawie także są ludzie, którzy wykonują taką pracę – znalazłam trzy osoby, które zgodziły się na spotkanie, ale wszystkie w ostatniej chwili odwoływały rozmowę, tłumacząc się zapisami dotyczącymi poufności w swoich umowach.

Wyobrażam sobie, że ta praca oparta jest wyłącznie na outsourcingu?

Tak, masz rację, to jest zupełny powrót do kolonialnego kapitalizmu. Swój projekt będę realizować w Manili, która jest głównym ośrodkiem takiej pracy, jeżeli chodzi o kontrolę treści dla amerykańskich firm. Tysiące ludzi na Filipinach całymi dniami oglądają ten internetowy horror, który sami tworzymy i którego nie przestajemy tworzyć. Myślę, że trzeba o tym głośno mówić. Ci ludzie powinni być algorytmem. Co więcej, korporacje, które ich zatrudniają, robią wiele, żebyśmy wierzyli, że tak jest. Podobnie jest z tzw. „click farms” – firmami, w których praca polega na klikaniu w przyciski i zakładaniu fałszywych kont w aplikacjach, aby wytworzyć wrażenie ich popularności.

Nie masz wrażenia, że – szczególnie, jeżeli zgodzimy, się, że żyjemy w epoce informacji – wszędzie jest bardzo dużo dezinformacji?

Tak! Totalnie zgadzam się ze stwierdzeniem: „nie wierz niczemu, co jest w internecie”. Jeżeli naprawdę chce się zgłębić jakiś temat, trzeba sięgać po badania i artykuły naukowe – wszystkie pozostałe materiały w sieci to po prostu czysty bełkot. To jest naprawdę niewiarygodne. Powiedziałabym, że 99% informacji, które znajduję w internecie, to jakieś bzdury wyssane z palca. Każde słowo, każdą linijkę tekstu, trzeba kwestionować i sprawdzać. Kilka miesięcy temu pewna szwedzka gazeta udostępniła na swoim Facebooku słynne zdjęcie dziecka poparzonego napalmem w czasie wojny w Wietnamie. Zdjęcie zostało usunięte pod zarzutem propagowania dziecięcej nagości. Wszystkie, ale to naprawdę wszystkie artykuły, które o tym czytałam, tłumaczyły, że to zrobił algorytm Facebooka. A przecież taką decyzję podejmuje człowiek. Kiedy zaczęłam interesować się tematem sztucznej inteligencji, czytałam wiele artykułów na ten temat. Niemal wszystkie okazały się później kompletną bzdurą. Wszelkie artykuły rozpoczynające się słowami typu: „Sztuczna inteligencja da początek straconemu pokoleniu” należy natychmiast zignorować!

No tak, ale to przecież taki chwytliwy tytuł… A poza tym należy podejść do tego z dystansem – w końcu żyjemy w czasach post-prawdy!

Nie lubię tego określenia „post-prawda”. Jak możemy być „po” czymś, czym na co dzień żyjemy? To samo zresztą dotyczy „post-internetu”.

Co byś poleciła użytkownikom internetu jako antidotum na tę codzienną fałszywych informacji i ćwiczeń w niewidzeniu?

Zawsze musimy utrzymywać nasz umysł w stanie gotowości, a nie biernie konsumować treści. Jest wiele ćwiczeń i eksperymentów, które można wykonywać, aby przezwyciężyć moc nieprawdziwych lub nie do końca prawdziwych historii, które codziennie przychodzą do nas i wpływają na nasze życie. Można też zrobić krok zupełnie radykalny, czyli mieć w dupie portale informacyjne, rzucić media społecznościowe i zobaczyć, co się stanie.

[1] Książkę można pobrać bezpłatnie ze strony http://www.laurenhuret.com/artificial-fear-intelligence-of-death/

[2] Elon Musk – przedsiębiorca, filantrop i miliarder, założyciel firm PayPal, SpaceX – której celem jest zmniejszenie kosztów lotów w kosmos – i Tesla, produkującej samochody na napęd elektryczny

[3] Lauren poleca nagrania Boston Dynamics: bostondynamics.com

[4] John Berger – brytyjski krytyk sztuki, autor popularnego programu telewizyjnego Sposoby widzenia i książki o tym samym tytule.